Percepção de profundidade para fotos de drones

Ajuda na busca por pessoas desaparecidas: Novo método JKU permite percepção tridimensional de imagens de drones em tempo real.

Isto funciona mesmo com oclusão forte e em longas distâncias. A percepção visual humana de profundidade, ou seja, a capacidade de perceber objectos a diferentes distâncias, baseia-se essencialmente no facto de os nossos olhos verem imagens ligeiramente diferentes em termos de perspectiva. Este efeito estereoscópico também é usado em cinemas 3D para fazer os filmes parecerem tridimensionais. Porém, não é apenas a visão humana que utiliza esse efeito, mas também a visão computacional. Isto significa que o computador processa imagens estereoscópicas ou multiscópicas (mais de duas) de diferentes perspectivas para calcular informações de profundidade da cena gravada.

No entanto, a percepção estereoscópica de profundidade não funciona para humanos e computadores se a cena observada estiver parcialmente obscurecida. Se o nosso cérebro ou o computador não conseguirem mais encontrar semelhanças suficientes em ambas as imagens, também não serão capazes de estimar a profundidade.

Visão humana e visão computacional se complementam

Um estudo conjunto entre o Instituto de Computação Gráfica da JKU (Chefe: Oliver Bimber) e a Universidade de Cambridge investigou agora se e sob quais condições a percepção estereoscópica de profundidade de cenas altamente ocluídas é possível. O resultado é surpreendente: nada com as atuais abordagens puramente baseadas em computador – mas é certamente possível graças à sinergia entre a visão computacional e a percepção visual humana.

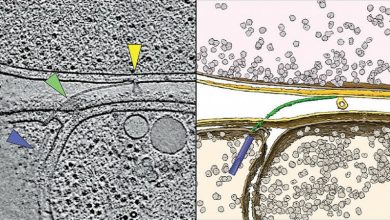

Os pesquisadores examinaram imagens térmicas estereoscópicas obtidas por drones em áreas densamente florestadas. O objetivo era encontrar pessoas escondidas na floresta e estimar seu tamanho. Descobriu-se que os métodos de reconstrução computacional 3D de última geração falharam 100% aqui. Cobaias humanas que visualizaram esses dados de imagem usando óculos 3D como parte de um estudo de usuário em larga escala inicialmente não tiveram mais sucesso.

Então chegou a hora de uma inovação: se os dados da imagem fossem calculados antecipadamente usando um método de imagem desenvolvido na JKU – Airborne Optical Sectioning (AOS) – para reduzir visualmente os obscurecimentos causados pela vegetação, então a detecção e estimativa de profundidade para humanos se tornaram muito possíveis. , enquanto os métodos puramente baseados em computador ainda não conseguiram produzir resultados.

“O estudo mostra que os humanos nem sempre podem ser completamente substituídos por computadores na resolução de problemas difíceis – mesmo na era da inteligência artificial. As sinergias entre os dois muitas vezes oferecem possibilidades que não podem ser alcançadas por um lado sozinho”, disse. diz o Prof.

Os resultados do estudo podem agora ser colocados em prática. Hoje, os drones são usados para procurar pessoas, combater incêndios florestais, observar a vida selvagem e muito mais. Porém, a percepção de profundidade não é suportada nas imagens 2D exibidas – mas seria uma vantagem para a interpretação da cena visualizada.

A chamada opção de visão em primeira pessoa (FPV), que alguns drones já oferecem hoje, permite a transmissão em tempo real dos dados de vídeo gravados para óculos de vídeo usados pelos pilotos. Isso dá aos pilotos uma visão direta do drone – embora ainda bidimensional, já que os drones padrão não usam câmeras estereoscópicas.

Aplicação prática

O novo processo AOS agora transmite dados de imagens estereoscópicas em tempo real, nas quais foi calculada a oclusão da vegetação, que é então exibida em óculos de vídeo 3D durante o voo. Isso funciona até mesmo com drones disponíveis comercialmente, que possuem apenas câmeras simples e nenhuma câmera estereoscópica. O AOS então calcula as imagens em perspectiva necessárias para a percepção 3D usando as imagens individuais gravadas ao longo da rota de voo.

Objetos distantes, cuja distância um ser humano não consegue mais reconhecer com sua pequena distância ocular de alguns centímetros, também podem ser distinguidos aqui por escala digital (ou seja, uma simulação de distâncias oculares de vários metros). Com este sistema, é agora possível ver e perceber imagens de drones ao vivo de forma imediata e tridimensional em toda a sua profundidade e em diferentes comprimentos de onda de luz (por exemplo, a faixa visível de câmeras coloridas regulares, ou a faixa infravermelha de câmeras de imagem térmica) – mesmo quando fortemente obscurecido pela vegetação e mesmo a grandes distâncias.

Os resultados do estudo serão agora publicados na renomada revista Nature Scientific Reports. A pré-publicação já está disponível: https://arxiv.org/abs/2310.16120