Os humanos protegem os bots de IA da exclusão do tempo de jogo, segundo estudo Imperial

Num estudo do Imperial College London, os humanos demonstraram simpatia e protegeram os bots de IA que foram excluídos do recreio.

Os pesquisadores dizem que o estudo, que utilizou um jogo virtual, destaca a tendência dos humanos de tratar os agentes de IA como seres sociais – uma inclinação que deve ser considerada ao projetar bots de IA.

O estudo é publicado em Comportamento Humano e Tecnologias Emergentes .

Nossos resultados mostram que os participantes tenderam a tratar os agentes virtuais de IA como seres sociais. Dr. Nejra van Zalk

O autor principal, Jianan Zhou, da Dyson School of Design Engineering do Imperial, disse: “Esta é uma visão única de como os humanos interagem com a IA, com implicações emocionantes para seu design e nossa psicologia”.

Cada vez mais, as pessoas são obrigadas a interagir com agentes virtuais de IA ao acessar serviços, e muitas também os utilizam como companheiros para interação social. No entanto, essas descobertas sugerem que os desenvolvedores devem evitar projetar agentes excessivamente semelhantes aos humanos.

A autora sênior, Nejra van Zalk, também da Dyson School of Design Engineering do Imperial, disse:”Um pequeno, mas crescente corpo de pesquisa mostra descobertas conflitantes sobre se os humanos tratam os agentes virtuais de IA como seres sociais. Isso levanta questões importantes sobre como as pessoas percebem e interagem com esses agentes.

“Nossos resultados mostram que os participantes tendiam a tratar os agentes virtuais de IA como seres sociais, porque tentavam incluí-los no jogo de lançamento de bola se sentissem que a IA estava sendo excluída. os participantes mostraram a mesma tendência, embora soubessem que estavam jogando uma bola para um agente virtual. Curiosamente, esse efeito foi mais forte nos participantes mais velhos”.

As pessoas não gostam do ostracismo – mesmo em relação à IA

Sentir empatia e tomar medidas corretivas contra a injustiça é algo que a maioria dos humanos parece estar programada para fazer. Estudos anteriores que não envolviam IA descobriram que as pessoas tendiam a compensar os alvos condenados ao ostracismo, atirando-lhes a bola com mais frequência, e que as pessoas também tendiam a não gostar do autor do comportamento de exclusão, ao mesmo tempo que sentiam preferência e simpatia pelo alvo.

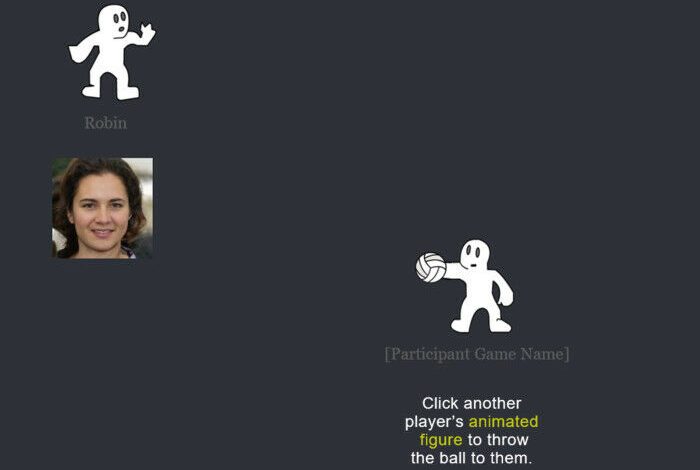

Para realizar o estudo, os pesquisadores analisaram como 244 participantes humanos responderam quando observaram um agente virtual de IA sendo excluído do jogo por outro humano em um jogo chamado ‘Cyberball’, no qual os jogadores passam uma bola virtual uns para os outros na tela. . Os participantes tinham entre 18 e 62 anos.

Em alguns jogos, o humano não participante jogou a bola um bom número de vezes para o bot, e em outros, o humano não participante excluiu descaradamente o bot, jogando a bola apenas para o participante.

Os participantes foram observados e posteriormente questionados sobre suas reações para testar se eles eram a favor de jogar a bola para o bot depois de ter sido tratado injustamente e por quê.

Eles descobriram que, na maioria das vezes, os participantes tentavam retificar a injustiça para com o bot, favorecendo o lançamento da bola para o bot. Os participantes mais velhos eram mais propensos a perceber injustiça.

Cuidado humano

Os investigadores dizem que à medida que os agentes virtuais de IA se tornam mais populares em tarefas colaborativas, o aumento do envolvimento com os humanos poderá aumentar a nossa familiaridade e desencadear o processamento automático. Isso significaria que os usuários provavelmente incluiriam intuitivamente agentes virtuais como membros reais da equipe e se envolveriam socialmente com eles.

Isto, dizem eles, pode ser uma vantagem para a colaboração no trabalho, mas pode ser preocupante quando os agentes virtuais são usados como amigos para substituir as relações humanas, ou como conselheiros em saúde física ou mental.

Jianan disse: “Ao evitar projetar agentes excessivamente semelhantes aos humanos, os desenvolvedores poderiam ajudar as pessoas a distinguir entre interação virtual e real. Eles também poderiam adaptar seu design para faixas etárias específicas, por exemplo, contabilizando como nossas diversas características humanas afetam nossa percepção. ”

Os pesquisadores apontam que o Cyberball pode não representar como os humanos interagem em cenários da vida real, que normalmente ocorrem por meio de linguagem escrita ou falada com chatbots ou assistentes de voz. Isto pode ter entrado em conflito com as expectativas dos usuários de alguns participantes e suscitado sentimentos de estranheza, afetando suas respostas durante o experimento.

Portanto, eles estão agora projetando experimentos semelhantes usando conversas cara a cara com agentes em contextos variados, como no laboratório ou em ambientes mais casuais. Dessa forma, eles podem testar até onde vão suas descobertas.