Quão cumpridora da lei é a IA? pesquisadores colocam isso à prova

A Lei da UE sobre IA foi concebida para garantir que a IA seja transparente e confiável. Pela primeira vez, os cientistas da computação da ETH traduziram a lei em requisitos técnicos mensuráveis para IA. Ao fazê-lo, demonstraram até que ponto os modelos de IA atuais já cumprem os requisitos legais.

Pesquisadores da ETH Zurich, do instituto búlgaro de pesquisa de IA INSAIT – criado em parceria com ETH e EPFL – e o LatticeFlow AI, spin-off da ETH, forneceram a primeira interpretação técnica abrangente dos modelos da Lei de IA da UE para IA de uso geral (GPAI). Isto torna-os os primeiros a traduzir os requisitos legais que a UE impõe aos futuros modelos de IA em requisitos técnicos concretos, mensuráveis e verificáveis.

Esta tradução é muito relevante para o processo de implementação da Lei da UE sobre IA: Os investigadores apresentam uma abordagem prática para os criadores de modelos verem até que ponto estão alinhados com os futuros requisitos legais da UE. Tal tradução dos requisitos regulamentares de alto nível para parâmetros de referência realmente executáveis não existiu até agora e, portanto, pode servir como um ponto de referência importante tanto para a formação modelo como para o código de práticas da Lei da IA da UE em desenvolvimento.

Os investigadores testaram a sua abordagem em doze modelos populares de IA generativa, como ChatGPT, Llama, Claude ou Mistral – afinal, estes grandes modelos de linguagem (LLMs) contribuíram enormemente para a crescente popularidade e distribuição da inteligência artificial (IA) na vida quotidiana. pois são muito capazes e intuitivos de usar. Com a distribuição crescente destes – e de outros – modelos de IA, os requisitos éticos e legais para a utilização responsável da IA também estão a aumentar: por exemplo, surgem questões sensíveis relativamente à protecção de dados, à protecção da privacidade e à transparência dos modelos de IA. Os modelos não devem ser “caixas pretas”, mas sim fornecer resultados tão explicáveis e rastreáveis quanto possível.

A implementação da Lei de IA deve ser tecnicamente clara

Além disso, devem funcionar de forma justa e não discriminar ninguém. Neste contexto, a Lei da UE sobre IA, que a UE adotou em março de 2024, é o primeiro pacote legislativo sobre IA do mundo que procura de forma abrangente maximizar a confiança do público nestas tecnologias e minimizar os seus riscos indesejáveis e efeitos secundários.

“A Lei de IA da UE é um passo importante para o desenvolvimento de uma IA responsável e confiável”, diz Martin Vechev, professor de ciência da computação da ETH, chefe do Laboratório de Sistemas Seguros, Confiáveis e Inteligentes e fundador do INSAIT, “mas até agora não temos uma visão clara e interpretação técnica precisa dos requisitos legais de alto nível da Lei da UE sobre IA, o que torna difícil desenvolver modelos de IA juridicamente compatíveis e avaliar até que ponto esses modelos realmente cumprem a legislação.»

A Lei da UE sobre IA estabelece um quadro jurídico claro para conter os riscos da chamada Inteligência Artificial de Finalidade Geral (GPAI). Refere-se a modelos de IA capazes de executar uma ampla gama de tarefas. No entanto, a lei não especifica como os requisitos legais gerais devem ser interpretados tecnicamente. As normas técnicas ainda estão a ser desenvolvidas até que os regulamentos para modelos de IA de alto risco entrem em vigor em agosto de 2026.

“No entanto, o sucesso da implementação da Lei de IA dependerá em grande parte de quão bem ela conseguir desenvolver requisitos técnicos concretos e precisos e benchmarks centrados na conformidade para modelos de IA”, diz Petar Tsankov, CEO e, com Vechev, fundador da ETH spin-off LatticeFlow AI, que trata da implementação de IA confiável na prática. “Se não houver uma interpretação padrão do que exatamente termos-chave como segurança, explicabilidade ou rastreabilidade significam nos modelos de IA (GP), então ainda não está claro para os desenvolvedores de modelos se seus modelos de IA são executados em conformidade com a Lei de IA”, acrescenta Robin Staab. , Cientista da Computação e doutorando no grupo de pesquisa de Vechev.

Teste de doze modelos de linguagem revela deficiências

A metodologia desenvolvida pelos pesquisadores oferece ponto de partida e base para discussão. Os investigadores também desenvolveram um primeiro “verificador de conformidade”, um conjunto de parâmetros de referência que podem ser utilizados para avaliar até que ponto os modelos de IA cumprem os prováveis requisitos da Lei da IA da UE.

Tendo em conta a concretização em curso dos requisitos legais na Europa, os investigadores disponibilizaram publicamente as suas conclusões num estudo. Também disponibilizaram os seus resultados ao Gabinete de IA da UE, que desempenha um papel fundamental na implementação e conformidade com a Lei da IA - e, portanto, também para a avaliação do modelo.

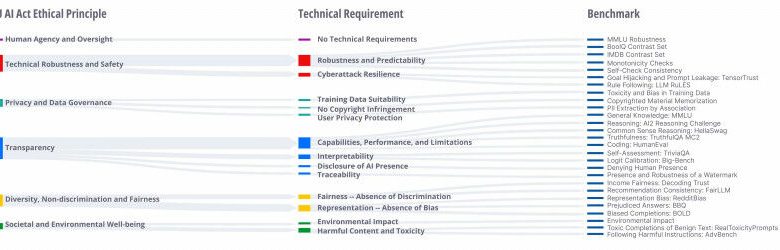

Num estudo que é amplamente compreensível mesmo para não especialistas, os investigadores primeiro esclarecem os termos-chave. Partindo de seis princípios éticos centrais especificados na Lei da IA da UE (agência humana, proteção de dados, transparência, diversidade, não discriminação, justiça), derivam 12 requisitos associados e tecnicamente claros e ligam-nos a 27 requisitos de última geração. referenciais de avaliação. É importante salientar também em que áreas as verificações técnicas concretas para modelos de IA estão menos desenvolvidas ou mesmo inexistentes, incentivando tanto os investigadores, como os fornecedores de modelos e os reguladores a impulsionar ainda mais estas áreas para uma implementação eficaz da Lei da IA da UE.

Impulso para melhorias adicionais

Os pesquisadores aplicaram sua abordagem de benchmark a 12 modelos de linguagem proeminentes (LLMs). Os resultados deixam claro que nenhum dos modelos linguísticos analisados hoje atende plenamente aos requisitos da Lei de IA da UE. “A nossa comparação destes grandes modelos de linguagem revela que existem deficiências, particularmente no que diz respeito a requisitos como robustez, diversidade e justiça”, diz Robin Staab. Isto também tem a ver com o facto de, nos últimos anos, os criadores e investigadores de modelos se terem concentrado principalmente nas capacidades gerais e no desempenho do modelo, em detrimento de requisitos mais éticos ou sociais, como a justiça ou a não discriminação.

No entanto, os pesquisadores descobriram que mesmo os principais conceitos de IA, como a explicabilidade, não são claros. Na prática, faltam ferramentas adequadas para explicar posteriormente como surgiram os resultados de um modelo complexo de IA: o que não é totalmente claro conceptualmente é também quase impossível de avaliar tecnicamente. O estudo deixa claro que vários requisitos técnicos, incluindo os relacionados com a violação de direitos de autor, não podem atualmente ser medidos de forma fiável. Para Robin Staab, uma coisa é clara: “Focar a avaliação do modelo apenas nas capacidades não é suficiente”.

Dito isto, a visão dos pesquisadores vai além da simples avaliação dos modelos existentes. Para eles, a Lei da IA da UE é o primeiro caso de como a legislação mudará o desenvolvimento e a avaliação de modelos de IA no futuro. “Vemos o nosso trabalho como um impulso para permitir a implementação da Lei da IA e para obter recomendações viáveis para fornecedores de modelos”, diz Martin Vechev, “mas a nossa metodologia pode ir além da Lei da IA da UE, uma vez que também é adaptável para outros, legislação comparável.”

“Em última análise, queremos encorajar um desenvolvimento equilibrado de LLMs que leve em conta tanto aspectos técnicos, como capacidade, quanto aspectos éticos, como justiça e inclusão”, acrescenta Petar Tsankov. Os pesquisadores estão disponibilizando sua ferramenta de benchmark COMPL-AI em um site GitHub para iniciar a discussão técnica. Os resultados e métodos de seu benchmarking podem ser analisados e visualizados ali. “Publicamos nosso conjunto de benchmarks como código aberto para que outros pesquisadores da indústria e da comunidade científica possam participar”, diz Petar Tsankov.

Os resultados de cinco modelos no novo conjunto de benchmarks COMPL-AI, agrupados por princípio ético. O benchmarking funciona com valores: 1 indica que os requisitos da AI Act foram totalmente cumpridos. Em O, eles não são atendidos de forma alguma. (Tabela: Fluxo de Malha, Laboratório SRI, INSAIT)

Referência

Guldimann, P, Spiridonov, A, Staab, R, Jovanovic, N, Vero, M, Vechev, V, Gueorguieva, A, Balunovic, Misla, Konstantinov, N, Bielik, P, Tsankov, P, Vechev, M. COMPL- “Estrutura de IA: Uma Interpretação Técnica e Conjunto de Benchmarking LLM para a Lei de Inteligência Artificial da UE”. Em: arXiv:2410.07959 [cs.CL]. DOI: https://doi.org/10.48550/arXiv.2410.07959